数据挖掘 part_4

Loss函数是机器学习模型优化的核心,梯度下降算法是优化的主要手段。本章系统介绍常见的Loss函数及其应用、梯度下降算法的变体、线性模型与Loss函数的结合、正...

本章介绍 KNN(k-最近邻)和决策树的原理、关键参数以及优缺点,重点展示相关的数学公式,以便深入理解其工作机制。

KNN 是一种基于实例的懒惰学习算法,其核心思想是通过计算测试样本与训练样本之间的距离,找到最近的 k 个样本,进行分类或回归:

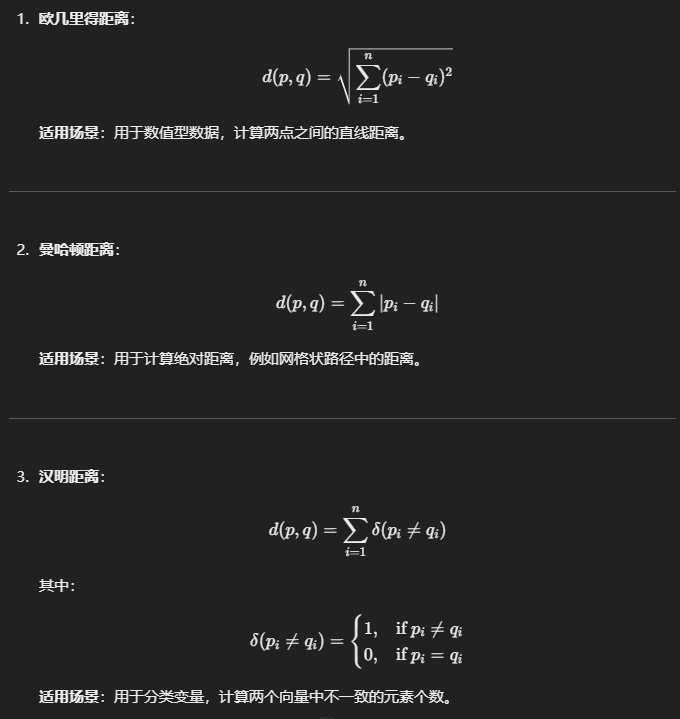

常见的距离度量方法:

在加权 KNN 中,距离较近的样本具有更高的权重:

wi = 1/d(x_m,x_i)^2

其中 d(x_m,x_i)为测试点 x_m与训练样本 x_i 的距离。

可以按照part_1最后介绍的几种方法进行选择,如:通过网格搜索找到指定指标最优时的k值

优点:

缺点:

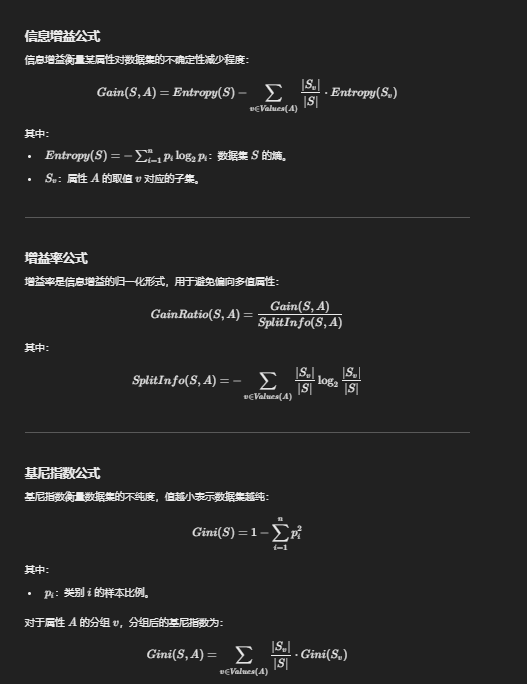

决策树是一种基于树结构的模型,通过递归划分数据集来构建分类或回归模型:

划分标准

优点:

缺点:

决策树的构建通常在以下条件下停止:

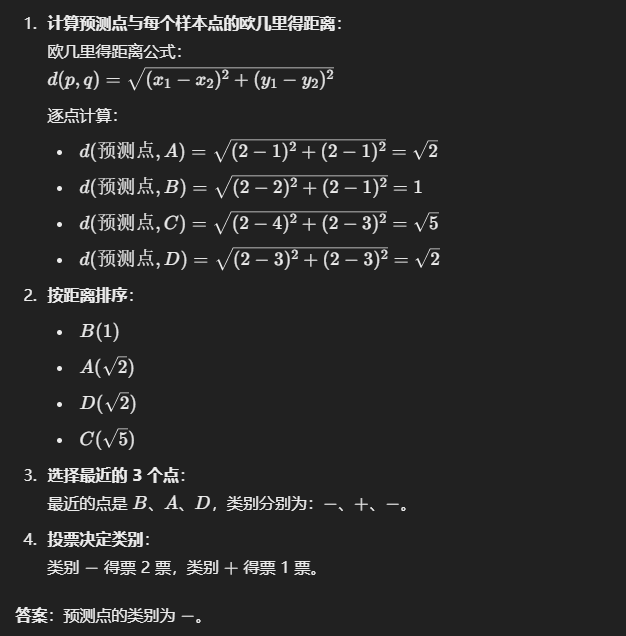

题目:已知如下数据集,k=3,预测点为 (2, 2):

| 样本点 | 坐标 (x, y) | 类别 |

|---|---|---|

| A | (1, 1) | + |

| B | (2, 1) | - |

| C | (4, 3) | + |

| D | (3, 3) | - |

解答步骤:

题目:假设数据为分类变量,使用汉明距离计算最近邻。

| 样本点 | 属性 1 | 属性 2 | 类别 |

|---|---|---|---|

| A | 高 | 男 | + |

| B | 中 | 女 | - |

| C | 高 | 女 | + |

测试点:(高, 女)。

解答步骤:

题目:使用信息增益选择划分属性。

| 天气 | 温度 | 玩游戏 |

|---|---|---|

| 晴 | 热 | 是 |

| 晴 | 热 | 否 |

| 阴 | 适中 | 是 |

| 雨 | 凉爽 | 否 |

解答步骤:略(就是我懒了,自己算一下吧)

答案:选择“天气”作为划分属性。

题目:使用基尼指数选择划分属性。

| 属性 A | 属性 B | 类别 |

|---|---|---|

| 高 | 是 | + |

| 低 | 否 | - |

| 中 | 是 | + |

解答步骤:略(就是我懒了,自己算一下吧)

答案:选择“属性 A”作为划分属性。

上一篇更回味

下一篇更精彩

评论区

预览: